Deep Learning: Wie selbstfahrende Autos Szenen besser verstehen

Anbieter zum Thema

Neue, an der Universität Freiburg entwickelte Methoden des Deep Learning verbessern die Wahrnehmung der Umgebung in selbstfahrenden Autos.

Selbstfahrende Autos sollten die Pixel des aufgenommenen Bildes Personen und Objekten zuordnen können, um sicher unterwegs zu sein.

Die Aufgabe zum Szenenverständnis wird zumeist mit einer Technik des maschinellen Lernens gelöst, dem so genannten Deep Learning (DL).

Dr. Abhinav Valada von der Universität Freiburg und sein Team haben ein neuartiges Verfahren entwickelt, das mittels künstlicher Intelligenz (KI) und Deep Learning visuelle Szenen schneller und effektiver erkennt.

Neue, an der Universität Freiburg entwickelte Methoden des Deep Learning verbessern die Wahrnehmung der Umgebung in selbstfahrenden Autos.

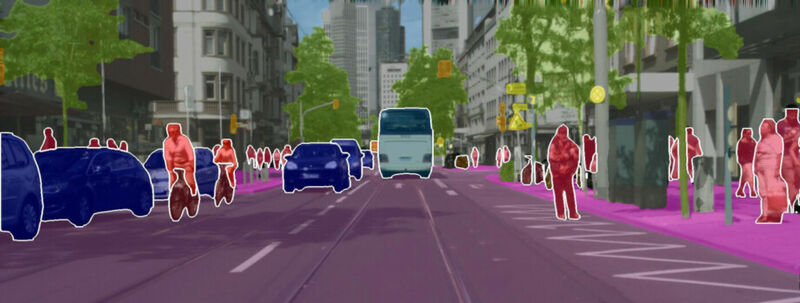

Menschen, Fahrräder, Autos oder Straße, Himmel, Gras: Welche Pixel eines Bildes gehören zu Personen oder Objekten, die sich im Vordergrund der Umgebung eines selbstfahrenden Autos befinden, und welche Pixel repräsentieren die städtische Kulisse? Diese Aufgabe, die als panoptische Segmentierung bezeichnet wird, ist ein grundlegendes Problem zahlreicher Bereiche wie selbstfahrende Autos, Robotik, Augmented Reality und sogar in der biomedizinischen Bildanalyse. Dr. Abhinav Valada, Inhaber der Juniorprofessur für Robot Learning am Institut für Informatik der Universität Freiburg und Mitglied von BrainLinks-BrainTools, geht dieser Forschungsfrage nach. Nun hat er mit seinem Team das neuartige Modell „EfficientPS" entwickelt, das mittels Künstlicher Intelligenz (KI) und Deep Learning visuelle Szenen schneller und effektiver erkennt.

Aufgabe zum Szenenverständnis mit Deep Learning gelöst

Die Aufgabe zum Szenenverständnis wird zumeist mit einer Technik des maschinellen Lernens gelöst, dem so genannten Deep Learning (DL). Bei diesem lernen künstliche neuronale Netze, die vom menschlichen Gehirn inspiriert sind, aus großen Datenmengen, erklärt der Freiburger Forscher. Öffentliche Benchmarks spielen eine wichtige Rolle bei der Messung des Fortschritts dieser Techniken. „Seit vielen Jahren konkurrieren Forschungsteams von Konzernen wie Google oder Uber um den Spitzenplatz bei diesen Benchmarks“, sagt Rohit Mohan aus Valadas Team. Die neue Methode der Freiburger Informatikerinnen und Informatiker erreichte nun jedoch den ersten Platz in Cityscapes, dem vermutlich einflussreichsten öffentlichen Benchmark für Methoden zum Szenen-Verständnis im autonomen Fahren. Auch bei anderen Benchmark-Datensätzen wie KITTI, Mapillary Vistas und IDD ist EfficientPS gelistet.

KI-Modell erkennt Szenen auch in Städten, die ihm nicht bekannt sind

Auf der Website des Projekts zeigt Valada Beispiele dafür, wie das Team verschiedene KI-Modelle auf verschiedenen Datensätzen trainiert hat. Die Ergebnisse werden dem jeweiligen mit der Kamera aufgenommenen Bild überlagert, wobei die Farben zeigen, welcher Objektklasse das Modell das jeweilige Pixel zuordnet. So sind zum Beispiel Autos blau, Menschen rot, Bäume grün und Gebäude grau markiert. Darüber hinaus zeichnet das KI-Modell auch einen Rahmen um jedes Objekt, das es als separate Einheit betrachtet. Den Freiburger Forschenden ist es gelungen, das Modell so zu trainieren, dass es die gelernten Informationen städtischer Szenen von Stuttgart nach New York City überträgt. Obwohl das KI-Modell nicht wusste, wie eine Stadt in den USA aussehen könnte, war es in der Lage, Szenen aus New York City genau zu erkennen.

Die meisten bisherigen Methoden, die sich diesem Problem widmen, benötigen große Datenmengen und sind für den Einsatz in realen Anwendungen wie der Robotik, die stark ressourcenbeschränkt sind, zu rechenintensiv, erklärt Valada: „Unser EfficientPS erreicht nicht nur eine hohe Ausgabequalität, es ist auch die rechnerisch effizienteste und schnellste Methode. Damit werden die Anwendungsbereiche, in denen EfficientPS eingesetzt werden kann, deutlich erweitert.“

Bild: Rot für Menschen, Blau für Autos: Eine neue Methode erkennt mittels Künstlicher Intelligenz (KI) visuelle Szenen schneller und effektiver. Bild: Abhinav Valada

Website mit Live-Demonstrationen unterschiedlicher KI-Modelle

Beispielvideo: Fahrt durch New York City

Erfahren Sie hier mehr über autonomes Fahren in der Simulation.

Lesen Sie auch: "3D-Modelle: Wie Experten mit KI Problemstellen schneller aufspüren"

:quality(80)/p7i.vogel.de/wcms/15/61/15611ff2086aa526d8dfc3eb9992248d/eplan-20eview-20ar-1--1024x576.jpeg)

:quality(80)/p7i.vogel.de/wcms/4c/e6/4ce68d7b0e76f0ec83f8d5e199dcd1ed/siemens-4320x2429.jpeg)

:quality(80)/p7i.vogel.de/wcms/15/11/15118c1434ac342c07c7666adea161da/pci23-1036-2850x1602.jpeg)

:quality(80)/p7i.vogel.de/wcms/19/1e/191e0a9024dfe56f8fb4e9b42dc0ee83/altair-newsroom-nr-hannovermesse2024-social-1120x630.jpeg)

:quality(80)/p7i.vogel.de/wcms/f3/9c/f39c16be30fccda88aa494f3bdb2a250/-dsc0871-1600x900.jpeg)

:quality(80)/p7i.vogel.de/wcms/9e/3a/9e3ab3604f797ac319fad53b08e110bc/arch-motorcycle-landscape-1500x843.jpeg)

:quality(80)/p7i.vogel.de/wcms/dd/94/dd94abe217cd99c88727fe2f7af9f037/1-1-mitsubishi-electric-fachpressetage-2024-sustainable-metal-recycling.jpeg)

:quality(80)/p7i.vogel.de/wcms/d6/93/d693f93fe28e2aab9b6390f839357291/siemens-simcenter-e-machine-design-02.png)

:quality(80)/p7i.vogel.de/wcms/1f/1a/1f1a781aa6e783a44e9d2f51a4dc346a/pr-2232-2250-bx4-imc-s-1500x844.jpeg)

:quality(80)/p7i.vogel.de/wcms/c1/fe/c1fe95fb9f92afc5d9e076a2969ca0eb/24-04-16-st-c3-b6ber-vb-aaa-20heilbronn-01-3000x1688.jpeg)

:quality(80)/p7i.vogel.de/wcms/04/80/048023f2828cb9eb3ad9b587d9725345/igus-2551x1435.jpeg)

:quality(80)/p7i.vogel.de/wcms/74/b1/74b1df2e6351192ac8c951f5cdb5c084/garchinaussenansicht-4320x2430.jpeg)

:quality(80)/p7i.vogel.de/wcms/c7/67/c767018de9897bb48c65e4c756307b41/altair-newsroom-nr-2024-google-partner-of-the-year-social-1200x630-1120x630.png)

:quality(80)/p7i.vogel.de/wcms/b7/d6/b7d6436d7da5cd8467e0d3ac9fe4da6a/131734-1500x843.jpeg)

:quality(80)/p7i.vogel.de/wcms/a0/86/a0865e32665ba836f070f5d8058cccff/cobot-discovery-page-6000x3377.jpeg)

:quality(80)/p7i.vogel.de/wcms/c8/6a/c86a9ebad226a43d067fbe5e1824b6ae/bearb-aufmacher-booster-20--20digitalisieren-20sie-20ihre-20ce-prozesse-blacksalmon-20via-20istock-1898x1067.jpeg)

:quality(80)/p7i.vogel.de/wcms/58/1a/581a442180e139806ee4c5efde1d5300/h-c3-bcngsberg-20e-rechnung-800x450.png)

:quality(80)/p7i.vogel.de/wcms/37/16/3716d454cd92a7c09e3bf633f63321c5/de-2024-02-800-phoenix-contact-aufmacher-930x523.jpeg)

:quality(80)/p7i.vogel.de/wcms/11/ed/11edc3e69ff3609cf257974c8de65fcc/240322-crc-1265x712.jpeg)

:quality(80)/p7i.vogel.de/wcms/5c/68/5c68e7bc2deefa9ca4cf326a72b54875/dc-ae-ctrlx-world-pi-02-1920x1080px-16x9cm-rgb-202404-1440x809.jpeg)

:quality(80)/p7i.vogel.de/wcms/ad/fd/adfd7b78c2e194ca43ed256448cf14e3/ar-alliance.jpeg)

:quality(80)/p7i.vogel.de/wcms/9f/e1/9fe195fbe5e41a46c6f19a2908c45085/3spin-learning-1.jpeg)

:quality(80)/p7i.vogel.de/wcms/69/b4/69b40a329d1c329315351c6973f9dcd2/dmitry-adobestock-401232340-1.jpeg)

:fill(fff,0)/images.vogel.de/vogelonline/companyimg/127700/127792/65.png)

:fill(fff,0)/p7i.vogel.de/companies/65/b9/65b90e0576a82/abj-logo-aktuell-2024-300x237.png)

:fill(fff,0)/p7i.vogel.de/companies/65/b8/65b8efaa567e9/logo-comsol-blue-1571x143-1-300x27-png.png)

:quality(80)/p7i.vogel.de/wcms/df/16/df16395bfb1eba35452489ab7cc0e36f/universitaet-kassel-paavo-blafield.jpeg)

:quality(80)/p7i.vogel.de/wcms/12/c0/12c0358f2f4bcdc0fe64f2086a3b6001/draggan2.jpeg)