Training für Drohnen: Mit zweistufigem Ansatz sicher auf Kurs

Anbieter zum Thema

Ein neuartiges zweistufiges Verfahren schafft eine Möglichkeit, vollständig mit simulierten Daten trainierte Drohnen sicher in der realen Welt einzusetzen.

Um autonom fliegen zu können, müssen Drohnen verstehen, was sie in ihrer Umgebung wahrnehmen, und auf dieser Grundlage Entscheidungen treffen.

Eine neuartige Methode, die von Forschern der Carnegie-Mellon-Universität entwickelt wurde, ermöglicht es den Fluggeräten, Wahrnehmung und Handlung getrennt voneinander zu erlernen.

Der zweistufige Ansatz überwindet die Lücke zwischen Simulation und Realität und schafft eine Möglichkeit, Drohnen, die vollständig mit simulierten Daten trainiert wurden, sicher in der realen Kursnavigation einzusetzen.

"Normalerweise werden Drohnen, sogar wenn sie mit den besten fotorealistischen Simulationsdaten trainiert wurden, in der realen Welt versagen, weil die Beleuchtung, Farben und Texturen noch zu unterschiedlich sind, um sie zu interpretieren", sagte Rogerio Bonatti, ein Doktorand am Institut für Robotik der Fakultät für Informatik. "Unser Wahrnehmungsmodul wird mit zwei Modalitäten trainiert, um die Robustheit gegenüber Umweltvariabilitäten zu erhöhen.

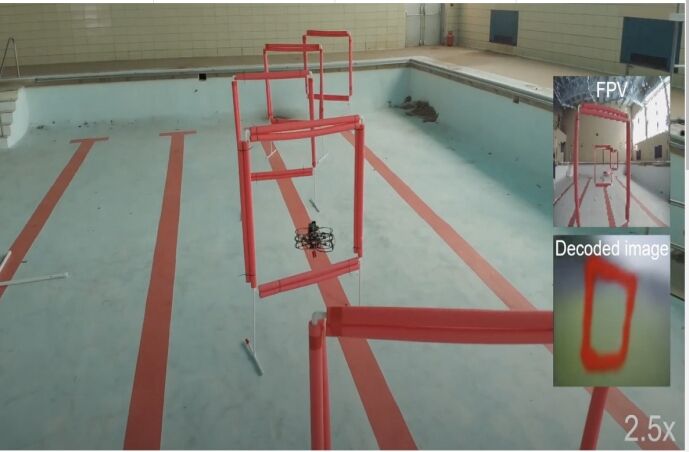

Die erste Modalität, mit deren Hilfe die Wahrnehmung der Drohne trainiert wird, ist das Bild. Die Forschenden benutzten einen fotorealistischen Simulator und schufen damit eine Umgebung, die die Drohne, ein Fußballfeld und rote quadratische Tore umfasste. Diese Tore befanden sich in zufälliger Anordnung ein Stück über den Boden und gaben damit die Flugbahn vor. Dann baute das Team aus Tausenden von zufällig generierten Drohnen- und Torkonfigurationen einen großen Datensatz mit simulierten Bildern auf.

Die zweite Modalität, die es für die Wahrnehmung braucht, ist die Kenntnis von der Position und Orientierung der Tore im Raum, die sich mit Hilfe des Datensatzes der simulierten Bilder herstellen ließ.

Das Training des Modells unter Verwendung mehrerer Modalitäten führt zu einer robusten Repräsentation der Erfahrung, das heißt, die Drohne kann das Wesen des Feldes und der Tore in einer Weise erfassen, die es erlaubt, die Simulation in die Realität zu übernehmen. Die Komprimierung der Bilder auf eine geringere Pixelzahl unterstützt diesen Prozess. Das Lernen aus einer niedrig aufgelösten Darstellung ermöglicht es dem Modell, durch das visuelle Rauschen in der realen Welt hindurch zu sehen und die Tore zu identifizieren.

Wenn die Wahrnehmung erlernt ist, setzen die Forschenden die Drohne innerhalb der Simulation ein, damit sie ihre Steuerung justieren kann -- oder die Art und Weise, wie sie sich real bewegt. In diesem Fall lernt sie, mit welchem Tempo sie durch den Kurs und die Tore navigieren muss. Da es sich um eine simulierte Umgebung handelt, kann ein Programm vor dem Einsatz die optimale Flugbahn der Drohne berechnen. Diese Methode ist gegenüber dem manuell überwachten Lernen mit einem erfahrenen Bediener zu bevorzugen, denn das Lernen in der realen Welt kann gefährlich, zeitaufwändig und teuer sein.

Die Drohne lernt, durch den Kurs zu navigieren, indem sie die von den Forschern diktierten Trainingsschritte durchläuft. Bonatti sagte, er fordere der Drohne bestimmte Geschicklichkeiten und Richtungswechsel ab, die sie in der realen Welt brauche. "Ich bringe die Drohne dazu, sich nach links und rechts in verschiedenen Bahnformen zu drehen, die schwieriger werden, je mehr visuelles Rauschen ich hinzufüge. Der Roboter lernt nicht, eine bestimmte Bahn nachzubilden. Vielmehr lernt er durch das strategische Steuern der simulierten Drohne alle Elemente und Bewegungsarten, die es der Drohne ermöglichen, autonom zu fliegen", sagt Bonatti.

Bonatti möchte die aktuelle Technologie der Fähigkeit des Menschen annähern, Umweltsignale zu interpretieren. "Der größte Teil der bisherigen Arbeit an autonomen Drohnenrennen konzentrierte sich auf die Entwicklung eines Systems, das mit zusätzlichen Sensoren und Software ergänzt wird, mit dem alleinigen Ziel der Geschwindigkeit. Stattdessen zielten wir darauf ab, ein rechnergestütztes, von der Funktion des menschlichen Gehirns inspiriertes Gefüge zu schaffen, um visuelle Informationen über eine verborgene Repräsentation den richtigen Steueraktionen zuzuordnen", sagte Bonatti.

Aber Drohnenrennen ist nur eine Möglichkeit für diese Art des Lernens. Die Methode der Trennung von Wahrnehmung und Kontrolle könnte auf viele verschiedene Aufgaben der künstlichen Intelligenz wie Autofahren oder Kochen angewandt werden. Während sich dieses Modell auf Bilder und Positionen stützt, um die Wahrnehmung zu trainieren, könnten andere Modalitäten wie Geräusche und Formen für Aufgaben wie das Identifizieren von Autos, Wildtieren oder Objekten verwendet werden.

Zu den Forschern, die zu dieser Arbeit beitragen, gehören Sebastian Scherer von der Carnegie Mellon-Universität sowie Ratnesh Madaan, Vibhav Vineet und Ashish Kapoor von der Microsoft Corporation.

Das Paper "Learning Visuomotor Policies for Aerial Navigation Using Cross-Modal Representations" wurde auf der Internationalen Konferenz über intelligente Roboter und Systeme (IROS) 2020 angenommen. Es ist Open Source und für andere Forscher verfügbar.

Erfahren Sie hier mehr darüber, wie sich die Navigation und Ortung autonomer Fahrzeuge virtuell testen lässt.

Lesen Sie auch: "Augmented-Reality-Visualisierung: Roboterinstallationen am Smartphone"

:quality(80)/p7i.vogel.de/wcms/15/61/15611ff2086aa526d8dfc3eb9992248d/eplan-20eview-20ar-1--1024x576.jpeg)

:quality(80)/p7i.vogel.de/wcms/4c/e6/4ce68d7b0e76f0ec83f8d5e199dcd1ed/siemens-4320x2429.jpeg)

:quality(80)/p7i.vogel.de/wcms/15/11/15118c1434ac342c07c7666adea161da/pci23-1036-2850x1602.jpeg)

:quality(80)/p7i.vogel.de/wcms/19/1e/191e0a9024dfe56f8fb4e9b42dc0ee83/altair-newsroom-nr-hannovermesse2024-social-1120x630.jpeg)

:quality(80)/p7i.vogel.de/wcms/f3/9c/f39c16be30fccda88aa494f3bdb2a250/-dsc0871-1600x900.jpeg)

:quality(80)/p7i.vogel.de/wcms/9e/3a/9e3ab3604f797ac319fad53b08e110bc/arch-motorcycle-landscape-1500x843.jpeg)

:quality(80)/p7i.vogel.de/wcms/dd/94/dd94abe217cd99c88727fe2f7af9f037/1-1-mitsubishi-electric-fachpressetage-2024-sustainable-metal-recycling.jpeg)

:quality(80)/p7i.vogel.de/wcms/d6/93/d693f93fe28e2aab9b6390f839357291/siemens-simcenter-e-machine-design-02.png)

:quality(80)/p7i.vogel.de/wcms/1f/1a/1f1a781aa6e783a44e9d2f51a4dc346a/pr-2232-2250-bx4-imc-s-1500x844.jpeg)

:quality(80)/p7i.vogel.de/wcms/c1/fe/c1fe95fb9f92afc5d9e076a2969ca0eb/24-04-16-st-c3-b6ber-vb-aaa-20heilbronn-01-3000x1688.jpeg)

:quality(80)/p7i.vogel.de/wcms/04/80/048023f2828cb9eb3ad9b587d9725345/igus-2551x1435.jpeg)

:quality(80)/p7i.vogel.de/wcms/74/b1/74b1df2e6351192ac8c951f5cdb5c084/garchinaussenansicht-4320x2430.jpeg)

:quality(80)/p7i.vogel.de/wcms/c7/67/c767018de9897bb48c65e4c756307b41/altair-newsroom-nr-2024-google-partner-of-the-year-social-1200x630-1120x630.png)

:quality(80)/p7i.vogel.de/wcms/b7/d6/b7d6436d7da5cd8467e0d3ac9fe4da6a/131734-1500x843.jpeg)

:quality(80)/p7i.vogel.de/wcms/a0/86/a0865e32665ba836f070f5d8058cccff/cobot-discovery-page-6000x3377.jpeg)

:quality(80)/p7i.vogel.de/wcms/c8/6a/c86a9ebad226a43d067fbe5e1824b6ae/bearb-aufmacher-booster-20--20digitalisieren-20sie-20ihre-20ce-prozesse-blacksalmon-20via-20istock-1898x1067.jpeg)

:quality(80)/p7i.vogel.de/wcms/58/1a/581a442180e139806ee4c5efde1d5300/h-c3-bcngsberg-20e-rechnung-800x450.png)

:quality(80)/p7i.vogel.de/wcms/37/16/3716d454cd92a7c09e3bf633f63321c5/de-2024-02-800-phoenix-contact-aufmacher-930x523.jpeg)

:quality(80)/p7i.vogel.de/wcms/11/ed/11edc3e69ff3609cf257974c8de65fcc/240322-crc-1265x712.jpeg)

:quality(80)/p7i.vogel.de/wcms/5c/68/5c68e7bc2deefa9ca4cf326a72b54875/dc-ae-ctrlx-world-pi-02-1920x1080px-16x9cm-rgb-202404-1440x809.jpeg)

:quality(80)/p7i.vogel.de/wcms/ad/fd/adfd7b78c2e194ca43ed256448cf14e3/ar-alliance.jpeg)

:quality(80)/p7i.vogel.de/wcms/9f/e1/9fe195fbe5e41a46c6f19a2908c45085/3spin-learning-1.jpeg)

:quality(80)/p7i.vogel.de/wcms/69/b4/69b40a329d1c329315351c6973f9dcd2/dmitry-adobestock-401232340-1.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/65/b8/65b8efaa567e9/logo-comsol-blue-1571x143-1-300x27-png.png)

:quality(80)/p7i.vogel.de/wcms/29/35/29350ec5dd453ff839a32f077b8bc5e4/de-2023-03-501-xsun-drivetech-3-c-maxon-kopie.jpeg)

:quality(80)/p7i.vogel.de/wcms/fc/40/fc40c1cfb324846046f8c88e9b972668/mit-neural-lithography-02-press.jpeg)